Dans le domaine commercial, on est passionné d’établir une base de données dans le souci de veille tarifaire car cette dernière aide à donner un prix de vente à ses produits ou service. On a besoin d’une grande quantité de données, telles que le prix, le stock, le classement, les commentaires des consommateurs. Ces éléments doivent souvent être mis en constante surveillance car chaque changement peut aider les analystes de marché à évaluer la valeur potentielle ou à prendre des décisions stratégiques importantes. Et voilà notre sujet : comment extraire ces données des pages web ? Cet article va introduire les avantages de price scraping et puis présenter quelques outils gratuits destinés au scraping de données sur le prix.

Pourquoi le price scraping ?

Le prix est un facteur clé pour toute industrie. Comment décider le prix pour que les commerçants puissent équilibrer le coût et le profit, pour que le prix corresponde au mieux à la valeur qu’on offre aux consommateurs, pour qu’on se trouve sur une place favorable dans le marché. Ce chiffre détermine également la clientèle et les concurrents. Tout cela signifie que la décision du prix doit être le résultat des recherches du marché, des analyses des données, parmi lesquelles, les données sur le prix de tous les produits similaires sur le marché. Et c’est pourquoi on parle du price scraping.

Difficulté du price scraping

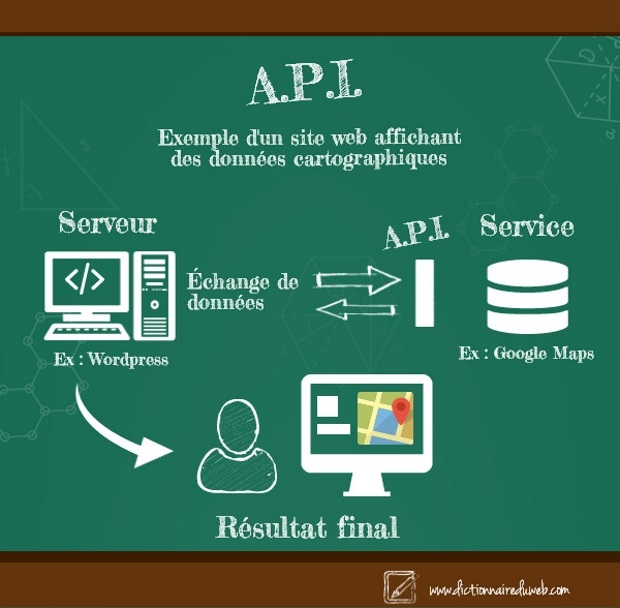

1. Les limites des API

Certains sites Web fournissent des API donnant aux utilisateurs l’accès à une partie de leurs données. Mais malgré ces API, il existe toujours des champs de données dont l’accès nous est interdit.

Par exemple, Amazon fournit une API pour la publicité sur les produits, mais l’API elle-même ne donne pas accès à toutes les informations affichées sur la page du produit, telles que le prix, etc. Dans ce cas-là, la seule façon de récupérer ces données est de construire notre propre scrawler par programmation ou de mettre en service des logiciels de scraping qui exécutent ce processus d’extraction automatiquement.

2. Le risque d’être bloqué

Parfois, même si on sait comment gratter des données par nous-même en programmant, par exemple en utilisant Ruby ou Python, divers problèmes se présentent et nous ne réussissons pas à gratter des données. Dans la plupart des cas, notre extraction risque d’être interrompue parce que le site cible détecte la répétition suspecte d’actions d’extraction en peu de temps. Si tel est le cas, il faut peut-être utiliser un proxy IP qui assure une rotation des IPs et nous éloigne du risque d’être bloqué.

Outils incontournables pour scraper le prix

Afin de rendre l’extraction de sites web accessible au plus grand nombre des personnes, je voudrais énumérer plusieurs outils de web scraping qui vous aident à gratter efficement et rapidement n’importe quel genre de donnée commerciale, y compris les prix, le stock, les avis, etc.

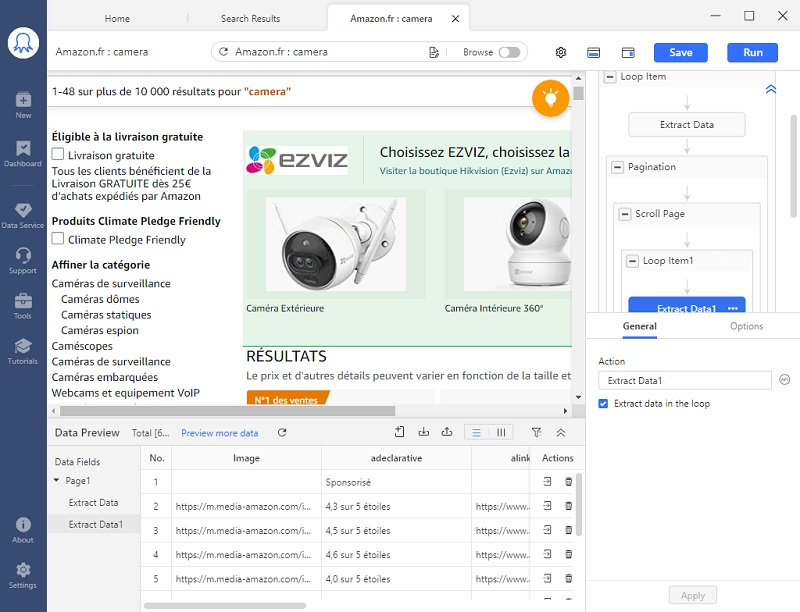

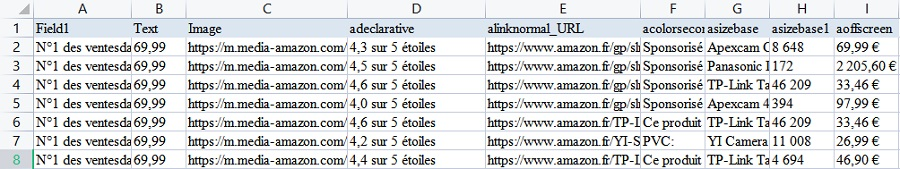

1. Octoparse

Vous pouvez utiliser ce logiciel de scraping pour scraper de nombreux sites Web, comme Amazon, eBay, AliExpress, Priceline, etc., pour extraire des données telles que les prix, les avis, les commentaires, etc.

L’équipe Octoparse a construit des modèles spécifiques pour ces sites populaires, et il suffit d’entrer quelques paramètres pour que l’extraction fonctionne.

Les connaissances préalables du codage ne sont pas importantes pour mener à bien l’extraction, mais ils doivent comprendre la logique de configurer une tâche d’extraction dans l’Octoparse dans le cas où la détection automatique ne fonctionne pas face à certains sites.

La configuration des tâches est facile à appréhender, l’interface utilisateur est très conviviale, d’autant que Octoparse offre pour ses utilisateurs un tutoriel complet. Il existe un volet Workflow Designer dans lequel vous pouvez pointer et faire glisser le texte, les images ou autres choses sur la page. Ce processus simule justement les comportements de navigation humains et extrait les données structurées dont les utilisateurs ont besoin.

Ce scraper vous permet de récupérer divers champs de données comme le prix, la description, les paramètres du produit, les commentaires des consommateurs, le note d’évaluation, etc. Vous pouvez aussi mettre en service IP proxy seulement en définissant efficacement et rapidement certaines options avancées.

Cette solution semble difficile et exige des utilisateurs une bonne connaissance à propos du codage ou des techniques informatiques avancées. Sinon, il pourrait s’agir d’une tâche difficile, voire impossible, à réaliser.

D’ailleurs, si vous souhaitez scraper et extraire les données à une vitesse beaucoup plus rapide, le service de cloud est à votre choix. Au moins 4 serveurs cloud travailleront simultanément sur votre tâche et à cela est ajouté le service Cloud de Octoparse. Voici une vidéo d’introduction de Octoparse Cloud Service.

En outre, Octoparse propose également un service de données : il vous suffit d’exprimer vos besoins en matière des données à scraper et l’équipe de support vous aidera à extraire les données dont vous avez besoin. Pour plus de détails, veuillez visiter le site officiel de l’Octoparse.

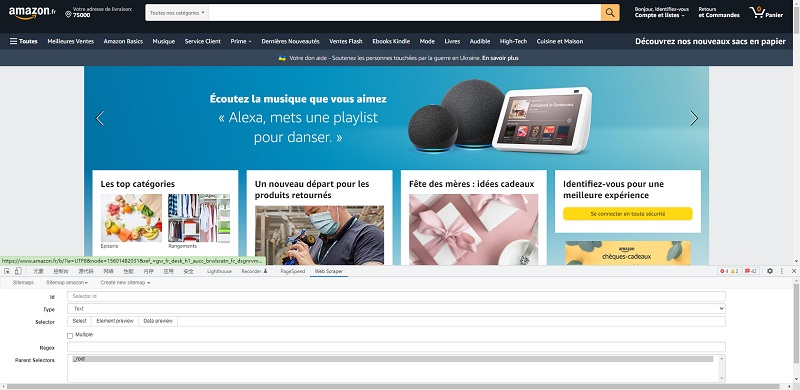

Webscraper est un outil d’extension de navigateur Web avec une interface de type pointer-cliquer. Le scraper Web est équipé de fonctions (disponibles pour les plans payants) telles que l’extraction cloud, le scraping programmé, la rotation IP, l’accès API, ce qui permet aux utilisateurs d’effectuer des extractions plus fréquemment et de récupérer un plus grand nombre de données.

Faute de certains modèles qui correspondent à l’industrie de l’e-commerce ou le scraping de l’Amazon, vous devez construire votre propre crawler en sélectionnant les informations de la liste que vous voulez sur la page web.

3. ScrapeBox

Les experts en SEO, les spécialistes du marketing en ligne et même les spammeurs devraient bien connaître ScrapeBox. Les utilisateurs peuvent facilement récolter les données d’un site Web pour récupérer des courriels, voir le classement des pages, vérifier le fonctionnement des proxies et la soumission RSS. En utilisant des milliers de proxies rotatifs, vous serez en mesure d’espionner les mots clés du site de vos concurrents, de faire des recherches sur les sites .gov, de récolter des données et de commenter sans être bloqué ou détecté.

En conclusion

Après que les données ont été saisies, il est temps d’en profiter.

En sachant le prix des produits fixé par les concurrents, on peut faire une comparaison et décider un prix plus concurrentiel. L’extraction Cloud fournie par l’Octoparse permet à ses utilisateurs de surveiller le changement du prix au temps réel, ce qui est essentiel pour répondre rapidement au changement du marché et occuper toujours une place favorable.