La cryptomonnaie est une monnaie numérique et virtuelle qui permet de faire des transactions sans intermédiaires, par le biais d’un réseau informatique décentralisé. Dès son apparition, la cryptomonnaie gagne progressivement une grande attention.

Beaucoup de monde participe à cette vague : certains ne tardent pas à créer des cryptos, les techniciens se dépêchent de miner des cryptomonnaies comme Bitcoin, les rechercheurs cherchent à analyser les raisons sociologiques, économiques de son apparition et de sa popularité, les investisseurs montrent un grand intérêt devant cette nouvelle chose. Et le site CoinMarketCap montre qu’il existe, au 27 décembre 2022, 21 530 cryptomonnaies, pour une valeur de 100 milliards de dollars : Bitcoin, Ethereum, Dogecoin, etc.

Quand beaucoup de gens mènent une étude sur les crytomonnaies, ici, nous voulons leur présenter une technique susceptible de faciliter le travail. C’est le web scraping qui peut extraire les données rapidement et à grande échelle.

Que peut faire le web scraping pour des recherches sur les cryptos ?

✍ Pour les investisseurs :

Bien qu’il s’agisse de monnaie numérique, elles sont vraiment utilisées pour faire des échanges dans l’ère d’aujourd’hui. Une valeur y est attachée et donc des investisseurs sont attirés. “Dans quelle cryptomonnaie investir ? “, “Quelle cryptomonnaie acheter ? “, “Quelles sont les cryptomonnaies permetteuses ? “, ce sont des questions qui restent à résoudre pour les investisseurs intéressés. De plus, pour peu qu’on jette un coup d’oeil aux sites de cryptomonnaies, on découvrira que le marché de cryptos change assez rapidement. Si un investisseur veut gagner de l’argent, il est nécessaire qu’il saisit bien les changements et le temps spécifique, la règle de ces changements.

✍ Pour les sociologues :

Le but des sociologues consiste plutôt à trouver les causes sociologiques/économiques/politiques de l’apparition des cryptos, à élucider les facteurs externes ou sociaux qui risquent d’exercer une influence sur la valeur et la popularité des cryptomonnaies.

Bien sûr, il y a beaucoup d’autres qui ont besoin de données sur les cryptomonnaies à des fins diverses. Quel que soit le but, ces analyses sont basées sur un ensemble de données complètes et riches. C’est là où s’introduit le web scraping.

Je n’essaie pas de m’attarder sur l’introduction de web scraping, puisque de bons articles ne manquent pas. Un résumé : le web scraping consiste à extraire automatiquement des données des cryptos depuis les pages Web.

Les données extraites avec le web scraping peuvent être exportées vers plusieurs formats, comme CSV, Excel, Google Sheet, ou votre propre base de données à l’aide de API et Zapier.

Pourquoi utiliser le web scraping ?

Puisque des sites web sont toujours disponibles sur Internet, pourquoi la peine d’extraire les données ? Je vois parfois que cette question est posée.

En effet, le web scraping s’attaque surtout au grand besoin de données. Un homme moyen qui garde l’intérêt pour une certaine cryptomonnaie peut bien sûr utiliser les sites de niche pour faire une analyse déjà assez approfondie. Mais quand on veut analyser des milliers de cryptomonnaies, il s’avère vraiment ennuyant de cliquer sur chacun, noter les info clés…

Si on utilise le web scraping pour extraire toutes les données, on peut les mettre dans les outils de visualisation selon ses besoins et analyser plusieurs cryptomonnaies en même temps.

Un autre cas assez typique est que pas mal de gens veulent vraiment créer une base de données propre à eux pour être le détenteur d’une richesse de données qu’il peut consulter à temps voulu. Dans ce cas, l’utilisation de ces données devient plus pratique.

Je ne suis pas expert dans la cryptomonnaie et ici, je n’énumère que des sénarios d’utilisation qui se produisent entre des utilisateurs d’Octoparse.

En bref, le web scraping est pour collecter des données, si vous en avez besoin, il est là pour faciliter votre travail !

Quels champs de données peut extraire le web scraping ?

Je peux répondre à cette question très rapidement : le web scraping peut extraire toutes les données affichées sur les pages web ou sur le HTML.

Plus précisément, le web scraping peut extraire les données de

nom

cours actuel

changement sur une heure/ 24 heures/ sept jours, volume sur 24 heures

capitalisation du marché

cours sur toutes les plate-formes d’échange

données historiques (date, capitalisation boursière, volume, cours d’ouverture, cours de fermeture)

…

et toutes ces données sur des dizaines de milliers de cryptomonnaies, sur presque toutes les sites de cryptomonnaies.

A quoi contribuent les données extraites avec le web scraping ?

Prévision du marché

Les investisseurs, les créateurs de cryptomonnaies et les mineurs collectent les données à partir des sites de cryptomonnaies pour poursuivre le changement des cours. Ces données les aident à prédire les tendances du marché et donc à faire des décisions pour réaliser les meilleurs profits. Et avec tant de données à la main, les comparaisons croisées deviennent plus faciles, permettant à se donner une vue d’ensemble du marché.

Recherches sur des cryptos

Les professionnels mènent une analyse sur les données pour identifier le schéma de leurs changements et pour aller plus loin, développer un algorithme de suivi. Une grande quantité de données sont nécessaires pour créer un tel modèle.

Etudes sur les facteurs d’influence sur la cryptomonnaie

Quand se produisent une augmentation ou une baisse remarquable ? On sait que les principales cryptomonnaies sont limitées en unités, par exemple, 21 millions de Bitcoins en circulation. L’offre étant limitée, plus de la demande est importante, et plus le cours augmente. Parfois, la demande est liée à des facteurs compliqués. Saisir ces moments particuliers et les comparer aux évènements internes ou externes permet à avoir une idée plus claire.

Comment extraire les données de crytomonnaies ?

Préparations :

Décider les sites web ou les pages web à scraper

Télécharger Octoparse et l’installer

Ici, je vous recommende surtout Octoparse, un outil non-codage et pas du tout difficile, qui est capable de vous éloigner de gaspillage de temps et de vous permettre de vous centraliser sur des affaires plus importantes.

Pour suivre le tutoriel suivant, vous utilisez peut-être l’URL :

Les étapes principales sont

- Ouvrir la page cible dans Octoparse

- Lancer l’auto-détection pour analyser la page et créer un workflow

- Lancer la tâche et exporter les données

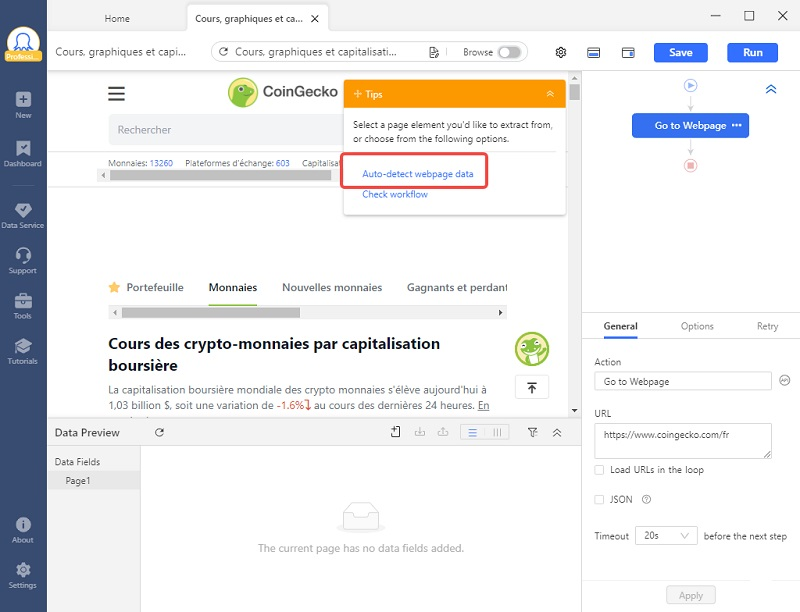

Étape 1 Ouvrir la page cible dans Octoparse

Entrer l’URL dans la barre de recherche d’Octoparse et puis cliquer “Start”

Étape 2 Lancer l’auto-détection pour analyser la page et créer un workflow

Cliquer sur “Auto-detect webpage data” dans le panneau de Tips. Quand la détection automatique est finie, vérifiez les données dans le panneau “Data preview” et vous pouvez supprimer ou renommer les champs de données s’il est nécessaire. Et après, cliquer “Create workflow”.

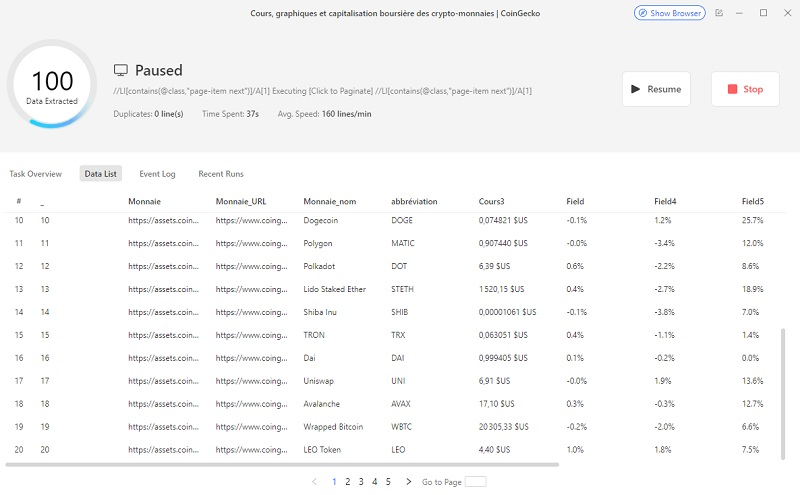

Étape 3 Lancer la tâche et exporter les données

Cliquez sur “Save” et puis “Run”.

La capture suivante montre les données extraites localement.

Le logiciel Octoparse est un outil qui est capable de faciliter et automatiser la collecte de données. Jusque maintenant, il est largement utilisé dans divers secteurs. Je vous invite à lire davantage pour savoir comment le web scraping peut promouvoir votre business.