Pour expliquer simplement et dacilement, un logiciel d’extraction de données peut être considéré comme un outil qui aide les utilisateurs à récupérer et à transformer rapidement toutes les données non structurées sur les pages Web en formats structurés avant de les exporter vers Excel, CSV, base de données, etc. Ce qui est fantastique chez les logiciels d’extraction de données réside dans le fait qu’ils libèrent tout le monde du travail fastidieux de copier et coller manuellement.

Il existe de nombreux logiciels d’extraction de données sur le marché, dont certains nécessitent des connaissances techniques et d’autres sont surtout développés à l’intention des non-codeurs. Je vais comparer en détail et en profondeur cinq principaux outils de web scraping tout en montrant le prix de chacun et la différence entre les services, les plans, etc.

Pourquoi les logiciels d’extraction de données ?

On va répondre à cette question par une énumération de plusieurs exemples de créer la valeur avec les données récupérées.

Un étudiant a besoin de données pour compléter ou supporter l’étude et le mémoire. [Cas d’utilisation : 30 Outils & Ressources pour les Recherches Académiques]

Un analyste de marketing a besoin de données qui sont à la base de toute stratégie de marketing. [Cas d’utilisation : L’hôtellerie : Web scraping aide à optimiser la stratégie de tarification]

Un PM (Product Manager) a besoin de données pour mener à bien l’analyse concurrentielle des différents produits.

Un PDG a besoin de données sur tous les secteurs d’activité qui va l’inspirer dans la prise de décision stratégique.

Un analyste de données ne peut rien s’il n’y pas de données.

Un propriétaire de magasin électronique a besoin de données pour savoir comment fluctuent les prix des produits similaires à ce que je vends. [Cas d’utilisation : Pourquoi le web scraping est-il important pour le secteur d’e-commerce?]

Un trader a besoin de données financières illimitées pour guider son prochain mouvement sur le marché. [Cas d’utilisation : Analyse des marchés boursiers à l’aide de web scraping]

Un travailleur dans le domaine de l’apprentissage automatique a besoin d’une quantité immense de données brutes pour entraîner les robots.

……

Des exemples de la sorte sont innombrables. Nous sommes dans l’ère informatique, ce qui nous lie déjà étroitement avec les données.

Pour lire davantage : nous avons rédigé un article spécialement pour expliquer 10 façons de tirer profit du web scraping, ou plus directement, 10 façons de gagner de l’argent avec la technique de web scraping. Je vous invite à le lire pour comprendre plus profondément le web scraping et sa valeur inestimable.

Quels logiciels ont été testés et comparés ?

On inclut dans notre comparaison les logiciels d’extraction de données les plus populaires parmi les amateurs et les professionnels de web scraping. Ils sont

1. Octoparse

Octoparse est un outil de web scraping facile à utiliser, qui est surtout développé à l’intention des non-codeurs pour faciliter l’extraction de données. Ce logiciel intelligent peut “deviner” automatiquement les champs de données que les utilisateurs souhaitent récupérer et puis lancer l’auto-détection fantastique, ce qui permet d’économiser beaucoup de temps et d’énergie.

Ce logiciel puissant est capable de traiter les sites Web dynamiques dont le contenu et la structure changent fréquemment, d’intergir avec tous genres de techniques utilisées par les sites, comme l’authentification, l’entrée de texte, le menu déroulant, le défilement infini, et beaucoup d’autres. De plus, Octoparse est équipé d’outils de XPath et d’expression régulière qui contribuent à extraire les données avec une grande précision.

L’extraction basée sur le cloud (fonctionnalité payante) et l’extraction locale (fonctionnalité gratuite) sont disponibles.

2. Parsehub

Parsehub est un autre logiciel convivial pour les non-programmeurs. Cette application de bureau est compatible avec divers systèmes, comme Windows, Mac OS et Linux.

A l’instar d’Octoparse, Parsehub peut traiter les scénarios complexes de scraping mentionnés précédemment. Cependant, bien que Parsehub ait pour but de proposer une expérience de web scraping facile, l’utilisateur typique aura besoin d’un peu de connaissance technique pour avoir accès à la plupart de ses fonctionnalités avancées.

3. Dexi.io

Dexi.io est un web scraper basé sur le cloud qui founit des services de développement, d’hébergement et de plannification. Cet outil est très puissant mais nécessite bel et bien des compétences en programmation plus avancées que Octoparse et Parsehub. Trois robots sont disponibles dans Dexi.io : extracteur, crawler et pipes.

Dexi.io est compatible avec de nombreux services tiers tels que les solveurs de captcha, le stockage sur Cloud et bien d’autres.

4. Mozenda

A la surprise de beaucoup, Mozenda est l’un des plus anciens logiciels d’extraction de données.

Il montre un haut niveau de cohérence tout en fournissant une interface utilisateur agréable et tout ce dont on aurq besoin pour démarrer une tâche de web scraping. Mozenda se compose de deux parties : Mozenda Web Console and Agent Builder. Le dernier est une application Windows utilisée pour configurer un projet de scraping tandis que le premier est une application Web permettant aux utilisateurs de plannifier l’exécution des projets ou d’accéder aux données récupérées.

Mozenda fournit un service de web scraping basé sur le cloud, qui est similaire à l’extraction de cloud offerte par Octoparse.

5. Import.io

Célèbre pour sa magie – transformer automatiquement les sites Web en données structurées, Import.io a gagné en popularité. Cependant, pas mal d’utilsateurs découvrent que ce logiciel n’est pas assez magique pour gérer différents types de sites Web. De toute façon, Import.io dispose d’une interface utilisateur agréable, et l’extraction de données en temps réel par le bias de API et JSON basées sur REST est possible.

Rapport détaillé et approfondi

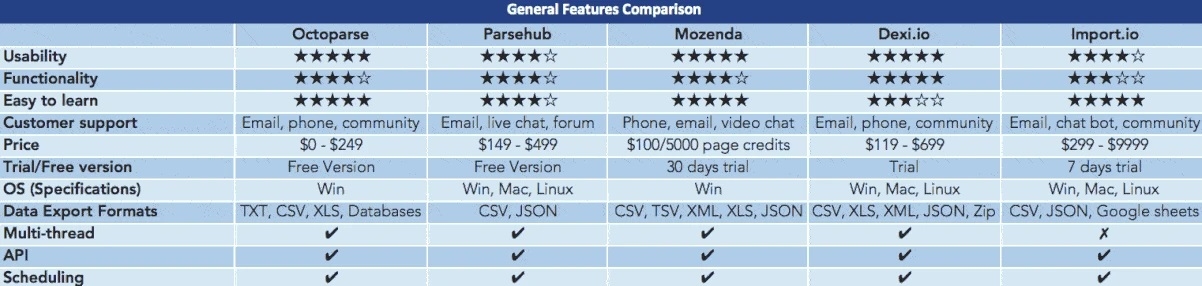

1. Comparaison sur les fonctions générales

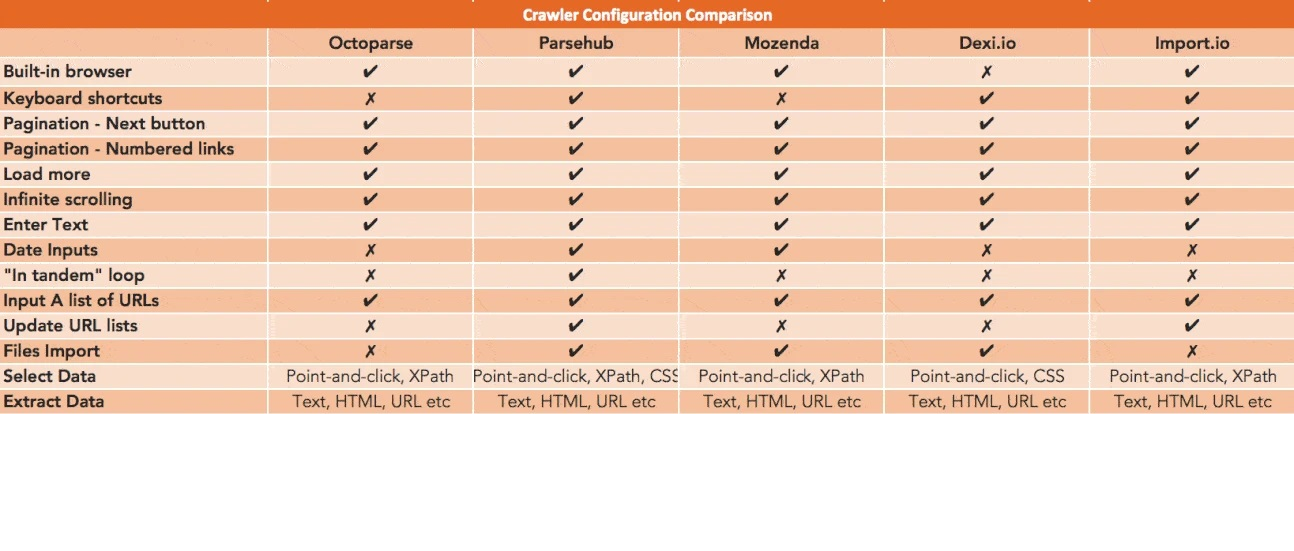

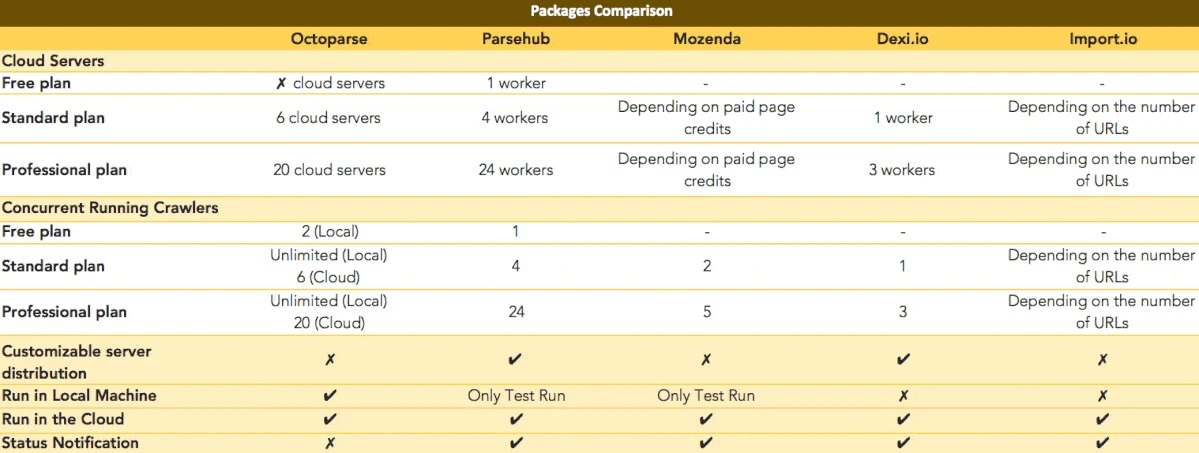

2. Comparaison sur la configuration de crawler

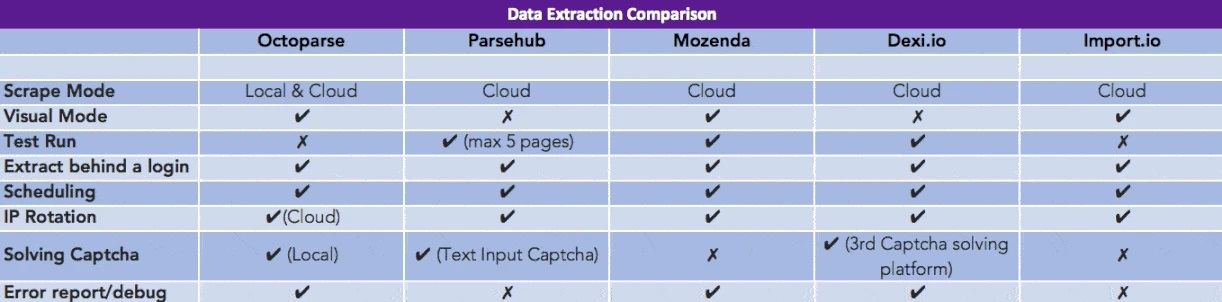

3. Comparaison sur l’extraction de données

4. Comparaison sur l’ensemble de service disponible

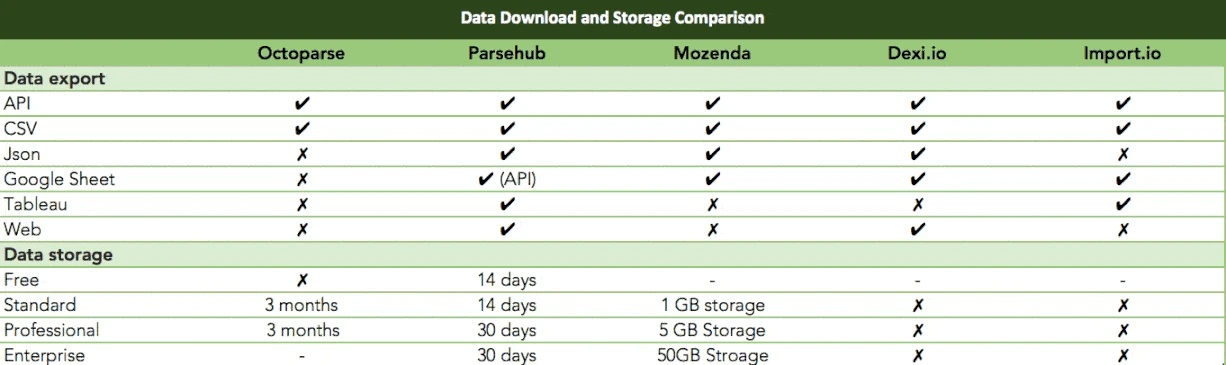

5. Comparaison sur l’exportation et le stockage de données

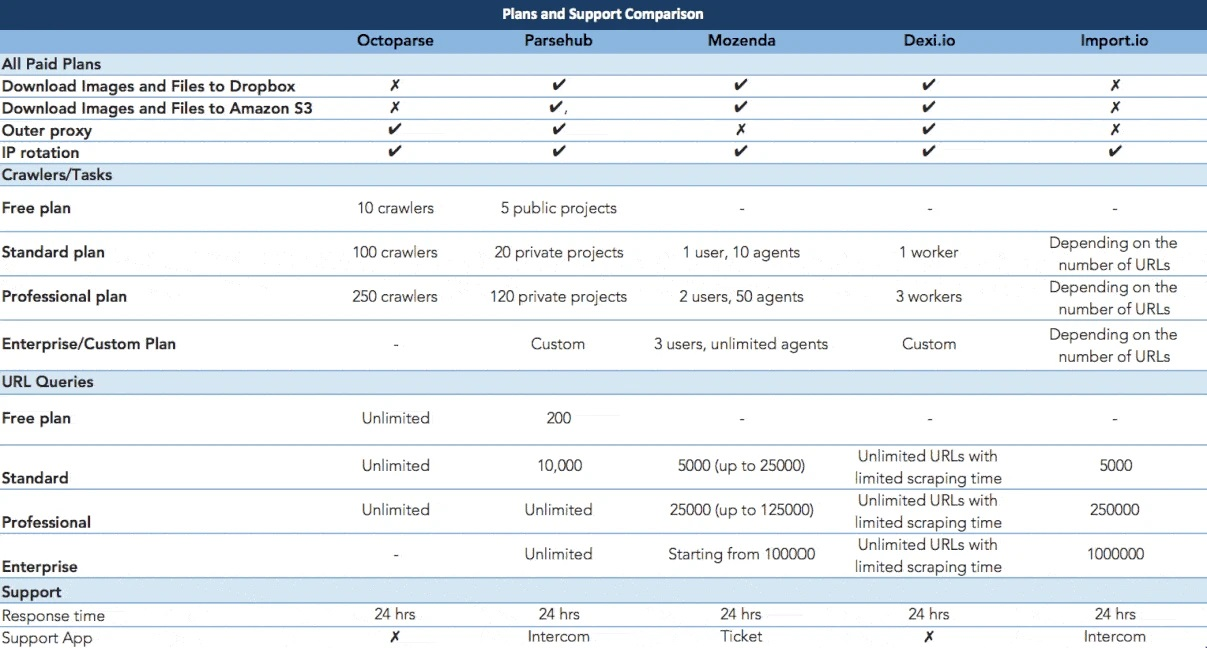

6. Comparaison sur le support et les services pour plans payant et gratuit et le support

En conclusion

On fait un résumé : Octoparse et Mozenda sont plus faciles à utiliser puisque tous les deux sont développés pour aider les non-programmeurs à effectuer le web scraping. Et donc, vous pouvez en profiter après avoir lu des tutoriels. Import.io n’est pas trop difficile mais ne fonctionne que les sites Web d’une structure simple. Dexi.io et Parsehub sont certainement deux outils puissants dotés de fonctionnalités robustes mais il est en même temps indéniable que des compétences techniques sont nécessaires pour en profiter pleinement.

Aucun outil n’est parfait et chacun a ses points forts et inconvénients. En d’autres termes, un certain outil est plus adapté, d’une manière ou autre, à un certain groupe de personnes.

J’espère sincèrement que cet article vous aide à trouver le logiciel d’extraction de données qui convient le mieux à vos besoin et que cela constitue un bon départ de votre voyage de web scraping.

Bon scraping !