Si vous cherchez des outils de web scraping et que vous tombez sur ce blog dont le titre vous laisse perplexe, prenez une grande respiration. Nous n’allons pas parler de la “recette de la belle soupe”, mais plutôt du Python Beautiful Soup, qui est populaire pour le web scraping.

Cet article vous donnera un aperçu fondamental de Beautiful Soup. Ensuite, nous discuterons d’un certain nombre d’alternatives à Beautiful Soup, dont l’une n’implique même pas de codage pour récupérer des données sur les sites web !

Qu’est-ce que Beautiful Soup ?

Beautiful Soup est une bibliothèque Python, pour le dire simplement. Dans le monde réel, une bibliothèque est une collection de livres destinés à un usage ultérieur. Dans le monde de la programmation, cela n’a pas beaucoup changé non plus. Une bibliothèque Python est une collection de codes ou de modules de codes que l’on peut utiliser dans un programme pour des opérations spécifiques. Beautiful Soup est l’une de ces bibliothèques, conçue comme un analyseur HTML pour des projets à exécution rapide tels que le screen-scraping.

Pour utiliser Beautiful Soup afin d’extraire des données des fichiers HTML et XML, vous devez d’abord télécharger les pages ciblées en utilisant la bibliothèque de requêtes Python. Après avoir effectué une requête GET à un serveur web, vous obtiendrez le contenu HTML de ces pages. Ensuite, vous pouvez importer la bibliothèque Beautiful Soup pour analyser les pages avec les codes de cette bibliothèque. Il existe des méthodes telles que find_all, get_text, find, etc. pour vous aider à obtenir les données que vous souhaitez.

En examinant ces méthodes, vous constaterez qu’elles sont très simples. En fait, c’est l’un des plus grands avantages de Beautiful Soup. Il donne aux utilisateurs des idiomes Pythoniques simples pour extraire des données, réduisant ainsi la quantité de code nécessaire au développement d’un scraper. De plus, il peut automatiquement convertir les documents entrants en Unicode et les documents sortants en UTF-8. Dans la plupart des cas, les utilisateurs n’ont pas à se préoccuper de l’encodage.

Cependant, tout a ses avantages et ses inconvénients. Beautiful Soup n’est pas difficile à apprendre, mais il convient mieux aux petits projets simples. De plus, il n’utilise que des sélecteurs CSS, ce qui permet de localiser les données dans les fichiers HTML en avançant, mais pas en reculant.

3 alternatives à Beautiful Soup en Python

Vous devez maintenant avoir une compréhension générale de Beautiful Soup. Ne vous inquiétez pas s’il s’avère que ce n’est pas l’outil qu’il vous faut. Dans cette section, nous allons vous présenter trois solutions de remplacement. Ces solutions pourraient, d’une certaine manière, répondre à vos attentes.

lxml

lxml est l’une des bibliothèques Python les plus rapides et les plus riches en fonctionnalités pour traiter le XML et le HTML. Elle peut être utilisée pour créer des documents HTML, lire des documents existants et trouver des éléments spécifiques dans les documents HTML. C’est pourquoi de nombreux développeurs l’ont appliquée au scraping de données pour obtenir de meilleurs résultats. Contrairement à Beautiful Soup, il offre XPath pour localiser les données en plus du sélecteur CSS. En outre, il est plus puissant et plus rapide dans l’analyse de documents volumineux.

parsel

Nous avons maintenant une autre bibliothèque Python appelée parsel. Il s’agit essentiellement d’une enveloppe UX de lxml, mais rationalisée pour le web scraping. Ainsi, elle possède des fonctions similaires à lxml pour extraire et supprimer des données de HTML et XML en utilisant XPath et des sélecteurs CSS. Les utilisateurs peuvent aller plus loin en utilisant des expressions régulières dans parsel pour obtenir des données à partir d’une chaîne de caractères d’un sélecteur.

html5lib

Il s’agit d’une bibliothèque Python écrite en code Python pur pour analyser le HTML. Elle lira l’arbre HTML d’une manière très similaire à celle d’un navigateur web. Par conséquent, elle peut décomposer presque chaque élément d’un document HTML en balises et parties séparées pour une variété de cas d’utilisation. De plus, il peut s’attaquer aux balises HTML cassées et ajouter les balises nécessaires pour compléter la structure. Il peut aussi être un backend de Beautiful Soup, mais il a des fonctions plus puissantes.

Nocode Web Scraper, une autre alternative à Beautiful Soup

Après avoir lu ce qui précède, vous êtes peut-être curieux de savoir si vous pouvez extraire des données d’un site Web si vous n’avez aucune expérience en matière de codage. La réponse est OUI ! Il existe aujourd’hui de nombreux outils de web scraping nocode, et certains d’entre eux peuvent être des alternatives à Beautiful Soup et aux bibliothèques Python mentionnées ci-dessus.

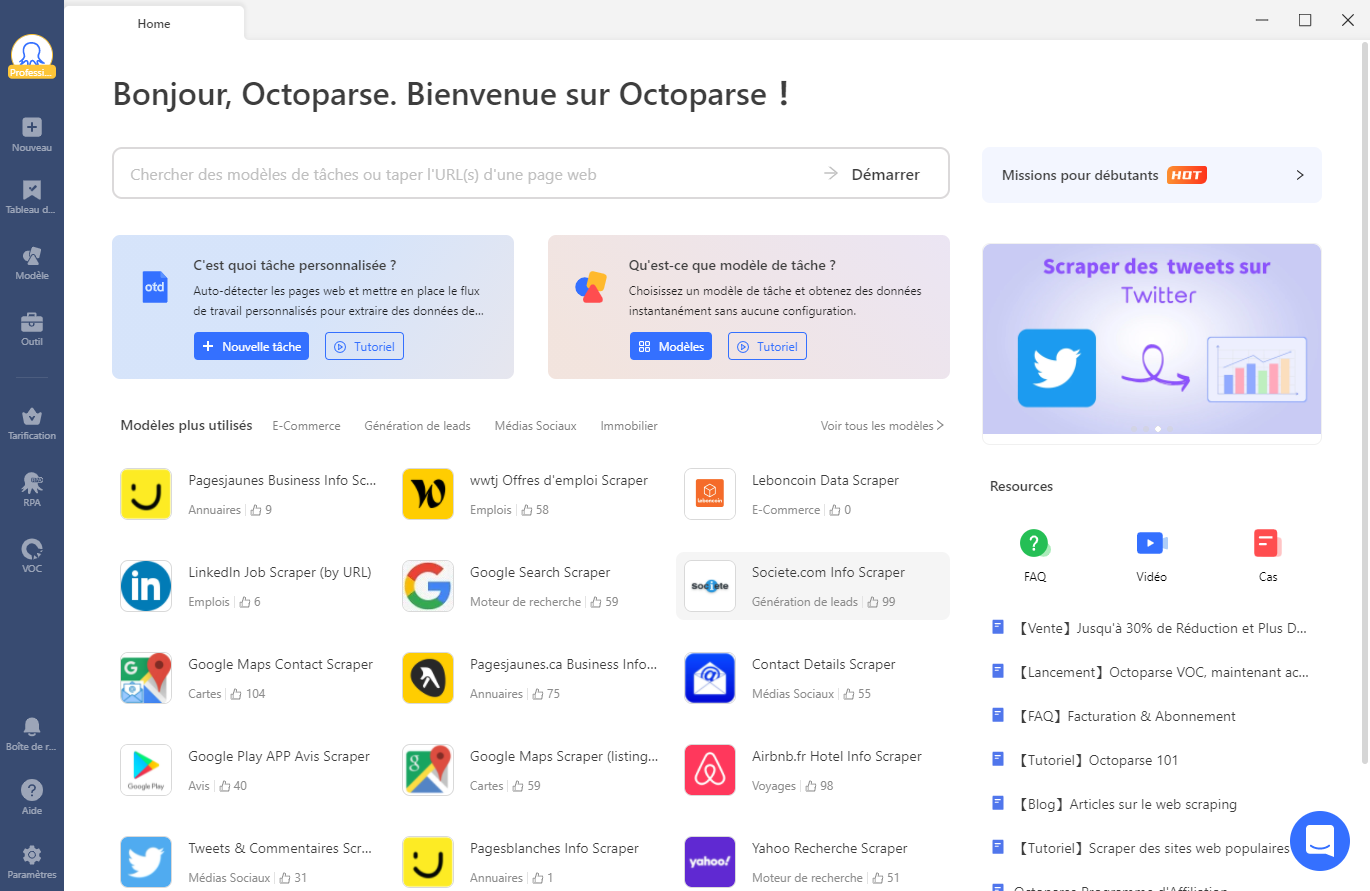

Dans cette partie, nous allons vous présenter comment vous pouvez extraire des données de pages web avec un outil facile à utiliser, Octoparse, sans avoir besoin de coder. Si vous ne l’avez jamais utilisé, n’hésitez pas à le télécharger et à l’installer sur votre appareil (Windows PC et MAC sont disponibles).

En général, vous pouvez facilement obtenir des données en suivant les étapes ci-dessous.

Étape 1 : Créer une tâche

Copiez l’URL de la page ciblée dont vous voulez extraire les données, et collez-la dans la barre de recherche, puis cliquez sur “Démarrer” pour créer une nouvelle tâche. Après cela, la page se chargera dans le navigateur intégré d’Octoparse en quelques secondes.

Étape 2 : Détection automatique des données de la page web

Une fois que la page a fini de se charger, cliquez sur “Détection des données de la page web” dans le panneau Astuces. Ensuite, Octoparse va scanner toute la page et “deviner” les champs de données que vous voulez. Il mettra en évidence les données détectées sur la page pour que vous puissiez les localiser. Vous pouvez également prévisualiser ces champs de données en bas de page et supprimer les données non désirées.

La fonction d’auto-détection peut vous aider à gagner beaucoup de temps dans la sélection des données. De plus, Octoparse offre des sélecteurs Xpath comme le font certaines bibliothèques Python. Vous pouvez l’utiliser pour sélectionner des champs de données dans Octoparse et obtenir des données plus précises. En particulier lorsque les structures des sites web sont compliquées.

Étape 3 : Créer le flux de travail

Assurez-vous que vous avez sélectionné tous les champs de données dont vous avez besoin, puis cliquez sur “Créer un flux de travail”. Ensuite, jetez un coup d’œil sur le côté droit où vous verrez un flux de travail décrivant chaque étape de la procédure de scraping. N’oubliez pas de vérifier que chaque étape fonctionne correctement en cliquant sur chaque étape pour prévisualiser l’action.

Étape 4 : Exécuter la tâche

Après avoir vérifié tous les détails, il est temps de lancer le scraper ! Cliquez sur “Exécuter” pour démarrer l’extraction, et Octoparse se chargera de tout le reste. Attendez que le processus se termine, puis exportez les données scrappées dans un fichier Excel, CSV ou JSON.

En conclusion

Dans cet article, nous avons présenté Beautiful Soup et trois autres bibliothèques Python pour l’extraction de données à partir de fichiers HTML et XML. Vous pouvez également trouver d’autres alternatives dans le top 10 des web scrapers open-source. Toutes ces bibliothèques sont faciles à utiliser si vous avez des connaissances de base en Python et en codage. En revanche, Octoparse est plus acceptable pour tout le monde, quelle que soit l’expérience en matière de codage. Si vous êtes à la recherche d’une solution de scraping de données sans codage, c’est une bonne option.