La recherche universitaire implique la collecte, l’analyse et l’interprétation de données et d’informations afin d’apporter des idées et des connaissances précieuses. Des données académiques utiles peuvent apporter des réponses à des questions de recherche, étayer des arguments fondés sur des preuves et faire progresser notre compréhension du monde.

Après avoir déterminé son sujet de recherche, l’étape suivante consiste à collecter les données importantes pour alimenter la recherche. Parfois, on doit extraire les données depuis des revues, des articles de recherches ou d’autres sources.

Cet article va cibler spécialement la collecte de données dans la recherche universitaire. On va commencer en discutant quatre questions le plus fréquemment posées et puis on va présenter une technique – le web scraping qui peut être parfaitement employé comme un des outils utiles dans la recherche universitaire pour faciliter l’extraction de données.

Questions générales sur la recherche universitaire et le Web Scraping

La recherche académique se concentre sur la découverte de nouveaux faits par le biais de diverses méthodes. C’est cruciale car elle génère des connaissances qui élargissent la compréhension humaine, stimulent l’innovation et résolvent des problèmes pratiques. Elle permet de répondre à des questions fondamentales, tester et élaborer des théories, résoudre les doutes et les débats, favoriser l’innovation, résoudre des problèmes pratiques. Dans tous les cas, la recherche de la connaissance pour elle-même finit par apporter des réponses, des idées et des perspectives qui repoussent les frontières du possible pour l’humanité. C’est la raison pour laquelle la recherche de la vérité par le biais d’une recherche rigoureuse a joué un rôle essentiel dans le progrès de l’humanité au cours de l’histoire.

Les données sont-elles essentielles à la recherche universitaire

La recherche universitaire s’appuie sur des données pour tester des hypothèses, vérifier des théories et tirer des conclusions fiables. Qu’il s’agisse d’expériences biologiques, d’enquêtes ou d’analyses historiques, les universitaires s’appuient sur différents types de données pour faire progresser la connaissance et la compréhension. Voici quelques raisons pour lesquelles les données sont indispensables à une recherche universitaire de qualité.

Les avantages du web scraping pour la recherche universitaire

Tout d’abord, je voudrais vous donner une introduction complète de web scraping. Il s’agit d’une technique qui permet d’extraire les données depuis des pages Web en les transformant des données structurées que vous pouvez les exporter et les sauvegarder dans un fichier Excel ou dans des bases de données. Si votre programme de recherche nécessite des données depuis des sources en ligne, le web scraping est un outil indispensable pour vous.

Imaginez : si vous menez une recherche sur un sujet social et vous voudriez télécharger tous les articles publiés sur un site d’articles pour une consultation ultérieure ou une analyse sémantique, vous pensez à copier manuellement le contenu et le coller dans votre fichier Word. N’oubliez pas qu’il s’agit souvent des centaines d’articles. Voilà un travail fastidieux et ennuyeux. Des erreurs humaines risquent de se présenter au cours de ce processus. Mais avec le web scraping, ce copier-coller de tous les articles sera fait automatiquement par le robot. Les avantages sont évidents :

Capabilité d’extraire les données depuis tous les sites : vous menez des recherches sur le marché financier et vous souhaitez obtenir les données là-dessus ? Vous êtes intéressé à l’opinion publique et vous avez besoin des discussions sur des forums ou réseaux sociaux ? Le web scraping peut être appliqué pour extraire les données depuis n’importe quel site !

Rapidité : C’est totalement possible d’obtenir des centaines de lignes de données en une minute.

Aucune erreur : Démarré, le robot va s’exécuter strictement selon le flux de travail qu’on a configuré, nous évitant des erreurs humaines.

Solution no-code : Quant au web scraping, certains pensent à écrire des codes Python pour réaliser l’extraction de données. En effet, on voit s’émerger ces deniers jours de bons outils de web scraping nocode, rendant le web scraping accessible à tout le monde.

Où trouver des données académiques ?

Les données académiques se trouvent dans diverses bases de données, sites web, revues et articles de recherche, dont les sources les plus courantes sont les suivantes

- Les bases de données des bibliothèques telles que JSTOR, ProQuest et EBSCO qui hébergent des millions de documents de recherche, d’articles de revues et de livres électroniques.

- Les dépôts en ligne tels que ResearchGate, Academia.edu et SSRN qui contiennent des articles scientifiques, des documents de travail et des profils de chercheurs.

- Dépôts institutionnels d’universités, d’instituts de recherche et d’organisations spécialisées dans des domaines spécifiques.

- Les plateformes de publication de revues académiques dans tous les domaines qui publient en permanence de nouvelles études et de nouveaux résultats.

- Les sites web et les actes de conférences qui mettent à la disposition du public les présentations, les affiches et les documents issus de conférences universitaires.

- Les moteurs de recherche tels que Google Scholar sont également de bons choix pour obtenir rapidement toutes les informations pertinentes.

L’abondance des données académiques dans ces diverses sources les rend inestimables pour les étudiants, les chercheurs et les éducateurs à la recherche d’informations et de points de vue de haute qualité.

Récupérer des données pour la recherche universitaire sans codage

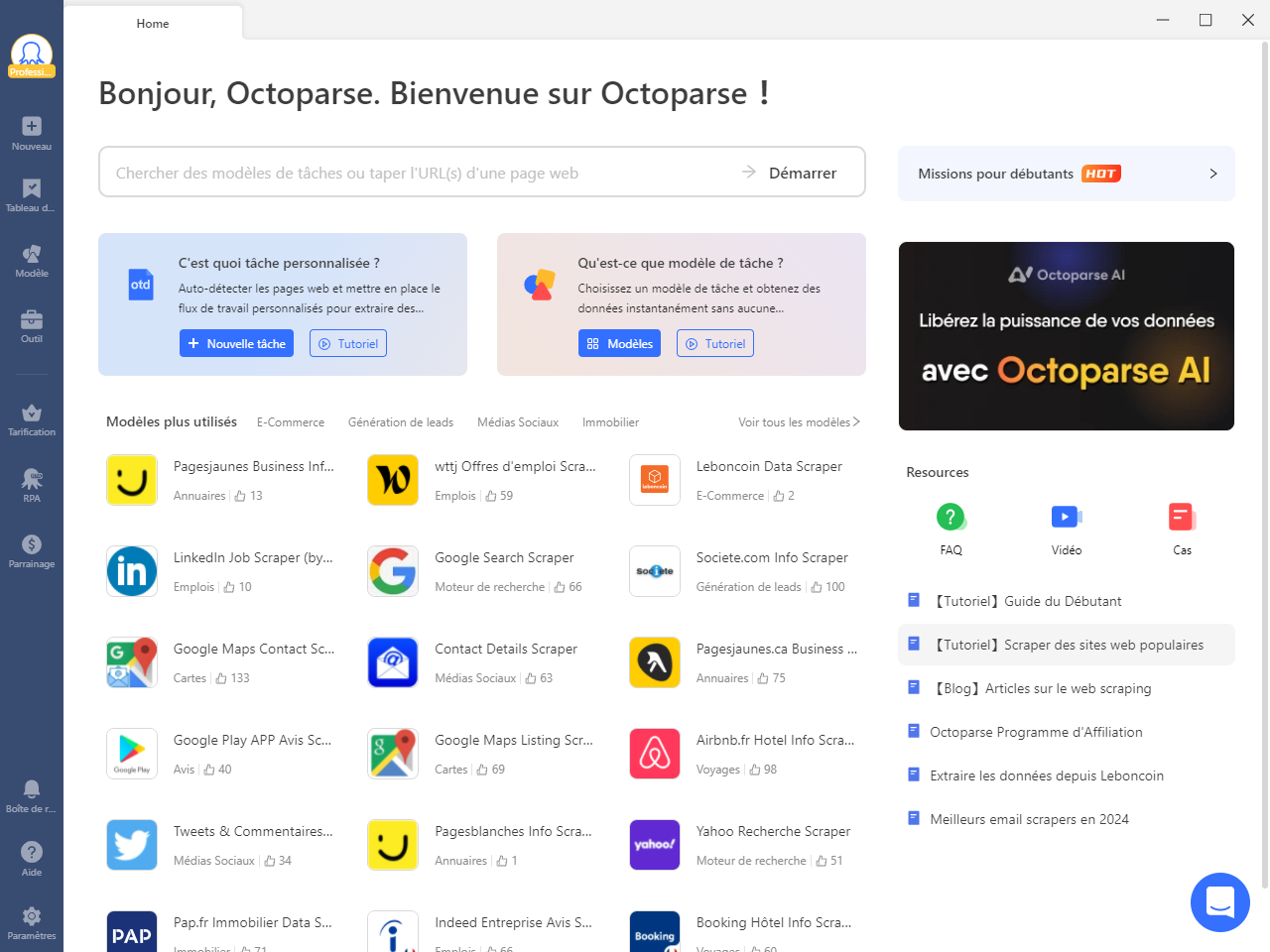

Quand il s’agit d’automatiser la collecte de données pour alimenter votre recherche académique, Octoparse est votre compagnon sans stress. Voilà les cinq étapes simples pour extraire des documents de recherche, des articles de journaux et d’autres données académiques à partir de sites Web avec Octoparse.

Étape 1 : Installer Octoparse

Téléchargez Octoparse sur votre appareil et créez un compte gratuit. L’interface intuitive vous permettra de scraper les données souhaitées en quelques minutes.

Étape 2 : Saisir l’URL du site académique

Copiez l’URL du site web que vous souhaitez récupérer – il peut s’agir de ResearchGate, JSTOR, des universités, etc. Collez l’URL dans Octoparse et cliquez sur « Démarrer » pour charger la page.

Étape 3 : Sélectionner les données dont vous avez besoin

Cliquez sur « Détecter automatiquement les données de la page web » et Octoparse mettra en évidence le texte, les tableaux et les autres éléments pertinents. Si Octoparse n’a pas fait une bonne « supposition », vous pouvez sélectionner manuellement les données spécifiques dont vous avez besoin en cliquant dessus sur la page. Vous pouvez également renommer et supprimer n’importe quel champ de données dans le panneau Aperçu des données en bas de la page.

Étape 4 : Créer un flux de travail d’extraction de données

Cliquez sur « Créer un flux de travail » après avoir sélectionné tous les champs de données souhaités. Vous trouverez alors un flux de travail qui s’affiche sur votre droite. Vous pouvez voir le processus étape par étape qu’Octoparse suivra pour extraire les données. Vous pouvez prévisualiser chaque étape en cliquant sur n’importe quelle action et en la modifiant si nécessaire.

Étape 5 : Exécuter et exporter les données

Cliquez sur « Exécuter » pour exécuter le scraper. Vous pouvez choisir de l’exécuter localement ou sur les serveurs d’Octoparse. L’exécution locale est plus adaptée aux petits projets, tandis que l’exécution dans le Cloud est plus adaptée au traitement des grands projets. Vous pouvez même programmer l’exécution fréquente du scraper pour obtenir automatiquement les données les plus récentes.

Une fois la tâche terminée, vous pouvez exporter les données académiques extraites sous forme de fichier Excel, CSV ou JSON, ou vers une base de données comme Google Sheets pour faciliter l’analyse.

La partie ci-dessus décrit des étapes simples de web scraping. Vous pouvez toujours consulter notre centre d’aide pour avoir une réponse à toutes vos questions au cours de tout ce processus.

En conclusion

Le web scraping peut vous aider à collecter des données de qualité à grande échelle, en vous concentrant sur ce dont vous avez besoin et rien d’autre. Cela améliore l’efficacité de la recherche, fait gagner un temps précieux et vous aide à produire de meilleurs résultats, qu’il s’agisse de réaliser un travail, de faire progresser vos connaissances ou de contribuer à une recherche ayant un impact. Essayez Octoparse dès maintenant et voyez avec quelle facilité vous pouvez automatiser la collecte de données académiques pour augmenter la productivité de votre recherche.

Transformer les sites web vers Excel, CSV, Google Sheets ou base de données.

Auto-détecter les sites Web et extraire les données sans aucun codage.

Scraper les sites populaires en quelques clics avec les modèles pré-construits.

Ne se trouver jamais bloqué grâce aux proxies IP et à l’API avancée.

Service Cloud pour programmer le scraping de données.