Le Google scraping est un sujet qui retient de plus en plus d’attention des growthhackers, des spécialistes de marketing digital, des experts en référencement. Selon une étude menée sur les utilisateurs Octoparse, Google occupe la première place de la liste de top 10 sites les plus scrapés.

Dans cet article, on va présenter quatre façons utiles pour extraire les résultats de recherche de Google vers CSV/Excel ou d’autres fichiers locaux. Et bien sûr, tant des méthodes no-code que quelques méthodes plus populaires sont incluses dans le but de satisfaire les besoins des personnes avec connaissance de programmation de différents niveaux.

À propos de Google scraping

Le Google Scraping désigne le fait de faire une extraction automatisée de données qui proviennent des résultats de recherche sur Google. Son utilisation permet d’extraire un grand nombre d’informations des résultats de la SERP (Search Engine Results Page), parmi lesquelles on trouve notamment des mots-clés, des liens, etc. Il est en général surtout utilisé pour analyser le positionnement des sites Web, observer les tendances d’une recherche ou extraire des données dans le cadre de diverses applications. En définitive, le scraping de Google constitue donc pour les entreprises un levier intéressant pour arriver à déceler des stratégies gagnantes et à récolter un grand nombre d’informations, notamment pour affiner les pratiques numériques.

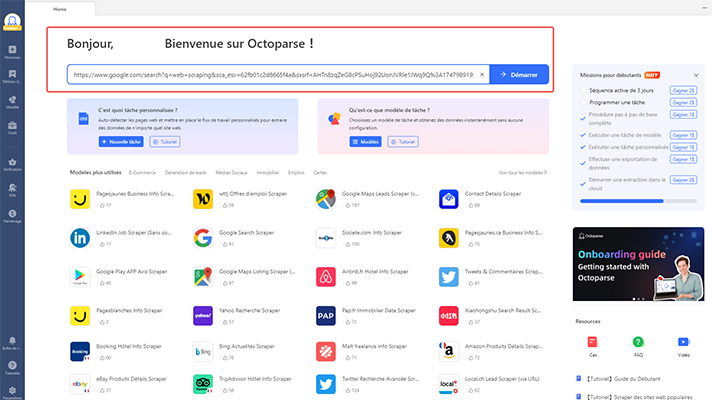

Méthode 1 : Utiliser les modèles Octoparse pour le Google scraping

L’Octoparse template, ce que l’on nommait modèle de web scraping, désigne des modèles préconstruits par l’équipe d’Octoparse qui couvrent les sites les plus visités au monde et les sites de référence de la spécialité pour chaque catégorie : du réseau social à l’immobilier en passant par l’emploi, l’annuaire, la finance, et tant d’autres.

Vu que les modèles sont déjà prêts-à-l’emploi, c’est très très facile de les utiliser. Il suffit aux utilisateurs de saisir quelques mots-clés ou l’URL cible et de cliquer pour démarrer. Par conséquent, ces modèles sont surtout populaires parmi les non-codeurs. S’agissant de Google scraping, on compte pour l’instant trois modèles différents : le premier demande d’entrer les mots-clés, le deuxième exige les URLs cibles, le troisième extrait les cinq premiers résultats pour chaque mot-clé. Si vous y êtes intéressé, je vous invite à télécharger Octoparse et à l’installer pour découvrir les modèles dans le logiciel de bureau.

https://www.octoparse.fr/template/google-search-scraper

Méthode 2 : Créer un Google scraper sans codage

En effet, il est tout à fait possible de réaliser vous-même un scraper Google, même sans avoir de connaissances en programmation. Pour créer un scraper sans coder, des outils comme Octoparse, Webscraper.io, Parsehub et divers services de web scraping existent.

La version gratuite d’Octoparse pourrait suffire à la plupart des tâches d’extraction de données simples, mais si vous en avez besoin de manière avancée avec des fonctionnalités particulières comme le Cloud, la programmation de l’extraction, la rotation des adresses IP ou les outils, il vous faudra potentiellement passer à une version payante ou à un service payant de données.

Dans la partie suivante, on va voir les étapes simples pour scraper Google avec la version gratuite d’Octoparse.

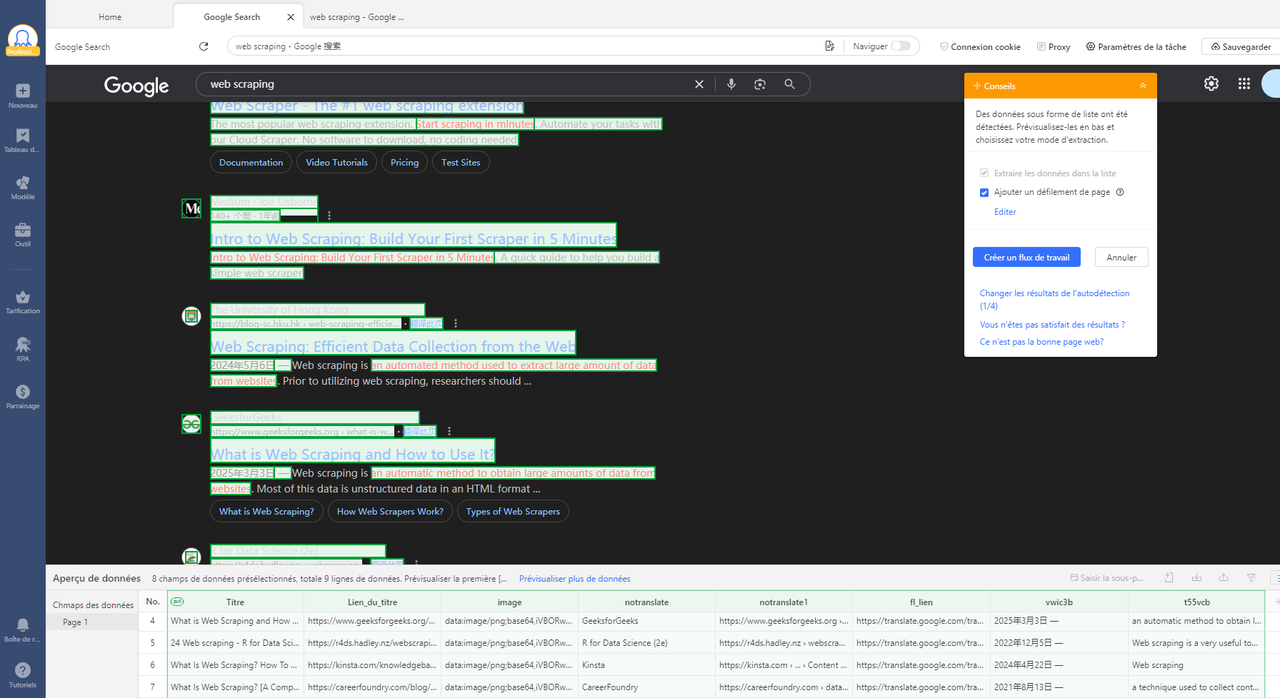

Étape 1 : Ouvrir Octoparse et entrer l’URL

Vous faites d’abord une recherche sur votre Google, et puis vous copiez-collez l’URL dans Octoparse. On entre dans Octoparse le mot-clé “web scraping” et puis je colle l’URL dans Octoparse, qui va vérifier ensuite si l’URL est valide ou pas.

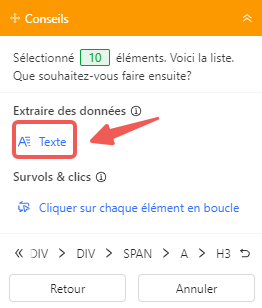

Étape 2 : Cliquer sur les données de la page de détail

En cliquant sur les éléments du premier résultat, ici on choisit les titres par exemple, et puis en cliquant sur “Texte” pour l’extraire des données. Octoparse va aspirer les éléments selon vos besoins, ce qui vous permet de les vérifier dans l’aperçu de données.

Étape 3 : Configurer la pagination avec l’auto-détection pour parcourir plusieurs pages

En général, vous avez besoin de données qui se répartissent sur plusieurs pages, donc il faut encore configurer une pagination. Simplement, avec la fonction de l’auto-détection, Octoparse analysera automatiquement la page web pour détecter les données et les liens de pagination. Vu que vous avez créé un flux de travail pour la troisième étape.

Étape 4 : Lancer le scraping et exporter les données

Après avoir vérifié toutes les informations, cliquez sur “Exécuter” pour lancer votre propre scraper. Ocroparse propose maintenant deux options pour exécuter les tâches. L’une est l’exécution sur l’appareil local. Vous devez garder votre appareil allumé tout au long du processus de scraping pour vous assurer que tout se passe comme prévu. L’autre option est l’exécution sur les serveurs Cloud d’Octoparse. Si vous l’optez, votre tâche sera envoyée sur des serveurs en nuage, qui pourront continuer à fonctionner pour vous 24 heures sur 24.

Une fois la tâche terminée, vous pouvez exporter les données dans un fichier Excel, CSV ou JSON, voire dans une base de données via API.

N’est-ce pas assez facile ? Pour l’utiliser, vous pouvez d’abord le télécharger et l’installer sur votre appareil. Au cas où vous voudriez essayer le service Cloud, vous pouvez demander un essai gratuit de 14 jours pour un plan premium.

Transformer les sites web vers Excel, CSV, Google Sheets ou base de données.

Auto-détecter les sites Web et extraire les données sans aucun codage.

Scraper les sites populaires en quelques clics avec les modèles pré-construits.

Ne se trouver jamais bloqué grâce aux proxies IP et à l’API avancée.

Service Cloud pour programmer le scraping de données.

Méthode 3 : Scraping Google avec Python

Si vous êtes à l’aise avec le codage, vous pouvez utiliser Python avec la Beautiful Soup Library pour collecter les résultats de recherche Google. Pour essayer cette méthode, vous devrez d’abord installer le langage Python sur votre ordinateur. En cas de besoin, vous pouvez consulter ce tutoriel sur l’installation de Python.

Et puis, vous devrez installer deux modules, bs4 et requests. bs4 (Beautiful Soup) est une bibliothèque Python utilisée pour lire des données XML et HTML à partir du web. requests est un module qui permet d’envoyer des requêtes HTTP au site web. Vous pouvez installer les deux modules avec la commande suivante dans votre terminal ou invite de commande.

pip install bs4

pip install requests

Une fois les modules bs4 et requests installés, vous pouvez utiliser le code suivant pour extraire les données.

La valeur de la variable de texte dans le code ci-dessous peut être changée. Par exemple, remplacer text=”web scraping” par text=”octoparse”.

Méthode 4 : Utilisation de l’API

Une autre méthode pour récupérer les résultats de recherche consiste à utiliser les outils de l’API. Les outils API sont des applications logicielles qui sont créées pour vous aider à extraire les résultats de recherche en temps réel. Ils peuvent gérer un énorme volume de demandes, et les réponses peuvent être structurées au format JSON, HTML ou CSV.

Ces outils API peuvent gérer les proxys, résoudre les captchas et analyser toutes sortes de riches données structurées à partir des recherches de Google. Avec API, vous obtiendrez des données avec tous les détails tels que le titre, le lien, la description, la date et la position SERP.

Certaines des API dsetinés à extraire les résultats de recherche les plus populaires sont :

Application du SEO

Une agence SEO peut tirer parti de plusieurs méthodes pour analyser la position de ses clients sur Google. Par exemple, elle peut configurer un scraper sans code, tel qu’Octoparse, afin d’automatiser la collecte des résultats de recherche pour des mots-clés spécifiques à l’aide du modèle Google Search Scraper. En exécutant ce scraper à intervalles réguliers, l’agence peut suivre de près l’évolution du classement des pages de ses clients, mais aussi celui de leurs concurrents. Cela lui permet d’ajuster sa stratégie SEO en temps réel, en fonction des variations observées.

En outre, en utilisant des outils plus sophistiqués comme Python ou des API, l’agence peut obtenir des informations très détaillées concernant la position sur la SERP, ainsi que des données relatives aux titres et aux descriptions des pages. Ces éléments sont essentiels pour la création de rapports précis, permettant ainsi aux clients de suivre leur progression et d’optimiser leur contenu afin d’améliorer leur classement sur Google.

Conseils pour l’extraction des résultats Google

Pour scraper les résultats de recherche Google, comme pour les autres, il est important de passer par un outil qui gère la rotation IP. En configurant un scraper, on se préoccupe toujours de la fréquence d’extraction, du délai entre deux actions, etc., pour simuler autant que possible une navigation réelle effectuée par l’être humain. Mais il est inévitable que Google détectera le robot vu que les étapes suivent le même ordre ou modèle. C’est là où sert la rotation IP. Quand Google comprend que tout est fait par un bot, vous pouvez changer d’IP pour recommencer un tour.

Un autre élément qui mérite attention est les CAPTCHAs. Vous avez probablement rencontré des RECAPTCHAs pendant votre navigation sur Google, qui vous demandent de vérifier que vous êtes humain. Dans un grand projet d’extraction de données Google, cela apparaît certainement. Donc, il faut compter sur des solveurs de captchas pour s’assurer que l’extraction fonctionne bien.

Pas mal d’outils de scraping sont déjà équipés de rotation IP et de solveurs de captcha, mais dans la plupart des cas, ce sont des services exclus aux utilisateurs payants où il faut acheter des crédits pour les utiliser.

En conclusion

Dans cet article, on a présenté quatre méthodes pratiques pour récupérer les résultats de recherche de Google. Octoparse template et configurer un scraper par lui-même à l’aide des outils de web scraping sont deux bons choix pour les non-codeurs. Les programmeurs ont plus de choix, comme Python ou API. J’espère que votre scraping de Google marche très bien ! Au cas où vous rencontriez des problèmes dans l’utilisation d’Octoparse, n’hésitez pas à contacter l’équipe de support.