Pour gérer avec succès un agrégateur d’offres d’emploi, vous avez besoin d’un bon scraper d’emploi pour obtenir facilement et rapidement des données d’emploi pertinentes et récentes depuis divers sources.

Dans cet article, nous allons vous expliquer comment créer un scraper d’emploi en quelques minutes pour alimenter votre agrégateur d’offres d’emploi.

Qu’est-ce que agrégateur d’offres d’emploi ?

Un agrégateur d’offres d’emploi s’appelle aussi métamoteurs d’offres d’emploi. Ces agrégateurs fonctionnent de la même façon que Google. Ils vont analyser plusieurs sources (internes ou externes) avant d’en extraire les informations pertinentes pour les utilisateurs. Un agrégateur d’offres d’emploi centralise les offres provenant de différents supports : des jobboards ou des sites carrière des entreprises. Indeed est un des principaux agrégateurs d’emploi en France.

Il existe deux genres d’agrégateurs d’emploi : agrégateur de niche (ou agrégateur spécialisé) et agrégateur généraliste. Le premier veut dire des sites qui touchent une audience plus ciblée, comme l’APEC spécialisé pour les cadres, fashionjobs spécialisé dans la mode, ou encore des sites spécialisés pour les étudiants, les freelances, etc. L’agrégateur généraliste s’adressent à tout le monde et ont donc une très grande audience. Les recruteurs ont accès à un nombre de candidatures plus élevé mais moins qualifié qu’avez l’agrégateur de niche.

📙 En savoir plus : Quelle est la différence entre le jobboard et les agrégateurs d’emploi ?

En bref, les jobboards sont des sites permettant aux recruteurs de déposer directement des annonces d’offre d’emploi tandis que les agrégateurs analysent les offres de sources externe ou interne pour offrir aux utilisateurs les informations les plus pertinentes. Veuillez lire cet article qui vous sera utile pour y tirer une réponse à cette question.

Solution pour alimenter un agrégateur d’emploi : web scraping

Comme ce qu’on explique plus tôt, les agrégateurs rassemblent des données provenant de autant de sites possibles. En effet, des sites d’agrégateurs sont assez populaires de nos jours. Beaucoup sont ceux qui sont plongés dans la création des agrégateurs de contenu, de produits en ligne, etc. Les comparateurs de prix sont un exemple typique.

Tous ces genres de sites d’agrégateurs nécessitent un grand nombre de données provenant de le plus de sites possible. C’est là où se situe l’extraction de données. Il existe pas mal de manières d’accéder à un grand nombre de données : utiliser les API officielles fournies par certains sites relatifs, écrire des codes pour effectuer le web scraping, et choisir des outils de web scraping.

Dans la partie suivante, on concentre plutôt sur la méthode d’utiliser les outils de web scraping.

Difficultés liées à la création d’un scraper d’emploi

Mais avant d’appliquer le web scraping dans la création d’un agrégateur d’offres d’emploi, jetons-nous un coup d’oeil rapide à plusieurs difficultés fréquentes impliquées dans la création d’un scraper d’emploi.

Nécessité de mises à jours fréquentes

Les entreprises mettent constamment à jour leur page de carrière et leur page profil sur les jobboards. En fait, certaines mettent ces pages à jour toutes les heures. Scraper ces pages Web régulièrement peut prendre du temps et coûter vraiment cher. Si vous recherchez également des offres d’emploi sur d’autres sources, le défi est encore là à relever.

Volume élevé de données d’emploi

Lorsque vous avez l’intention de parcourir les différents jobboards et les pages Web de carrière des entreprises, vous devez vous préparer à gérer un gros volume de données. Avec une quantité importante de données à extraire, le web scraping prendra un long temps et cela pourrait être très frustrant.

Extraction de données à travers plusieurs plateformes

Pour obtenir les meilleures et les plus récentes offres d’emploi, vous devez extraire les données de nombreux sites Web. Un crawler ne peut fonctionner qu’avec un seul site Web. Et si on veut parcourir plusieurs sites, il faut adapter le crawler pour scraper tous les sites cibles.

Comment Octoparse résout ces difficultés ?

Au lieu de créer un scraper d’emploi à partir de zéro avec Python ou d’autres langues de programmation, vous pouvez choisir de créer un scraper d’offres d’emploi avec Octoparse. Beaucoup de technologies révolutionnaires ont été mises en oeuvre pour résoudre toutes les difficultés que vous risquez de rencontrer lors de l’extraction de données.

Allons découvrir les solutions proposées par Octoparse.

Scraping planifié pour suivre les mises à jour

Il est difficile de suivre les mises à jour régulières sur les jobboards ou sur les pages Web de carrière des entreprises. Au lieu de parcourir ces sites manuellement tous les jours, Octoparse vous propose le scraping planifié. Vous pouvez lancer les tâches à un intervalle régulier pour faire le web scraping toutes les jours/heures, par exemple. A l’heure fixée, l’outil parcourt les pages et récupère les données que vous souhaitez récupérer.

Grâce à la solution de scraping planifié d’Octoparse, vous pouvez récupérer les dernières offres d’emploi et les présenter sur votre agrégateur d’emploi.

De plus, l’extraction incrémentielle qui consiste à sauter les pages déjà extraites est disponible dans Octoparse. Ainsi vous pouvez extraire les données de manière beaucoup plus efficace.

Scraping sur Cloud et connection API

Le scraping et l’extraction d’une multitude de sites prennent beaucoup de temps et l’extraction sur Cloud est là pour vous éloigner de la gaspillage de temps. Le service de Cloud proposé par Octoparse utilise plusieurs systèmes basés sur nuage pour explorer simultanément plusieurs sites Web et récupérer les données dont vous avez besoin.

L’API d’Octoparse vous permet d’obtenir les données où que vous soyez dans le monde et d’avoir accès à des mises à jour constantes des données qui sont automatiquement envoyées dans votre base de données. Et pour ces opérations, vous n’avez pas besoin d’ouvrir le logicel.

Service de création de crawlers pour tout site

Si vous voulez vous priver du trouble de créer des crawlers vous-même, vous pouvez simplement faire appel au service de création de crawlers proposé par Octoparse. Tout ce que vous avez à faire est d’indiquer les sites Web à scraper et les champs de données à récupérer. L’étape suivante est d’exécuter les crawlers vous-même dans Octoparse. Évidemment, il n’y a pas du tout une courbe d’apprentissage.

Mais vous le savez aussi, il s’agit d’un service payant. Le prix commence à 399 $. Si vous ne souhaitez pas dépenser autant d’argent, vous pouvez utiliser des modèles déjà construits par l’équipe d’Octoparse ou configurer vous-même un crawler avec l’aide du support Octoparse. Et le suivant, c’est un tutoriel riche.

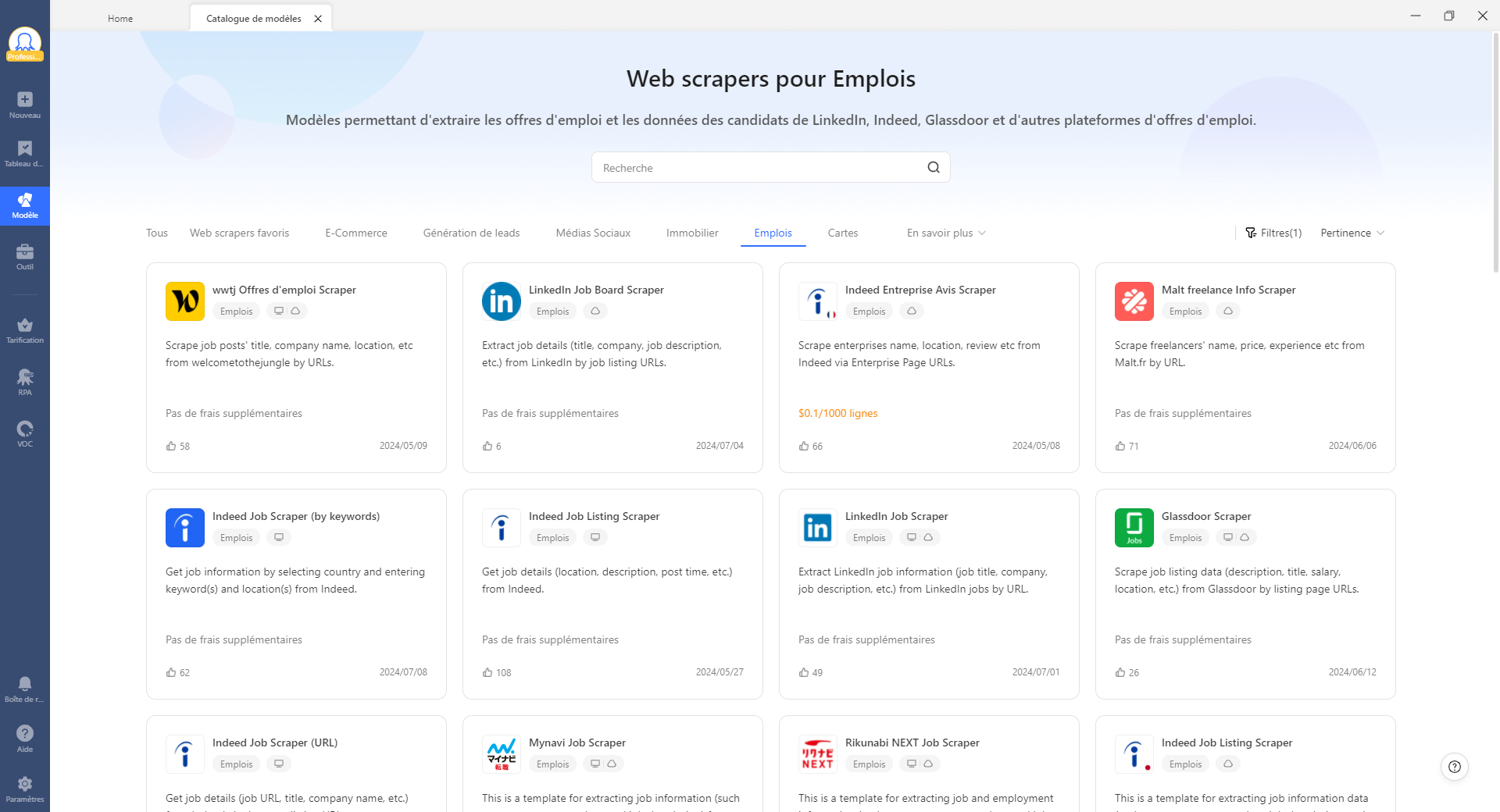

Utiliser un modèle de web scraping d’emploi

Devant tant de sites d’emploi, il est stressant de créer des crawlers respectivement pour chacun d’entre eux. Heureusement, Octoparse a créé pour ses utilisateurs un ensemble de modèles d’emploi qui sont prêts à utiliser. Il suffit aux utilisateurs d’entrer l’URL cible et quelques autres paramètres nécessaires pour que le robot exécute automatiquement le web scraping.

Jusque maintenant, les modèles couvrent déjà

Indeed

Glassdor

Welcome to the Jungle

Malt

Emploi-territorial, etc.

https://www.octoparse.fr/template/wwtj-offres-scraper

Créer un scraper d’emploi sous le mode avancé

Le mode avancé est très puissant et flexible. Si vous souhaitez extraire des données de sites Web complexes ou les sites que les modèles d’Octoparse ne couvrent pas encore, le mode avancé est un excellent choix.

Avec le mode avancé, vous pouvez extraire toutes les formes de données : texte, image, HTML, etc. En fait, il vous permet de créer un flux de travail capable d’interagir avec les sites Web pour effectuer des actions complexes comme la recherche de mots clés, l’authentification de connexion, le Captcha, le téléchargement de fichers, etc.

Bien que tout cela semble très difficile, l’auto-détection et l’interface pointer-cliquer sont là vous aider à maîtriser en peu de temps. La vidéo suivante donne un tutoriel étape par étape. Et pour un tutoriel en texte, veuillez consulter notre centre d’aide.

En conclusion

Un site d’agrégateur d’offres d’emploi est une bonne idée business à l’heure actuelle. De nombreux demandeurs d’emploi consultent des sites d’emploi pour trouver des postes intéressants. S’il semble difficile pour un agrégateur généraliste d’attirer du trafic, vous pouvez penser à créer un agrégateur de niche. Dans la plupart de cas, les recruteurs accordent plus d’attention à des sites d’emploi de niche, donc un business permettant.