Zillow est l’un des sites Web les plus populaires utilisés pour rechercher des maisons, vérifier leur prix et trouver des agents immobiliers. Il contient également de nombreuses données sur les maisons locales, leurs prix et les agents immobiliers. C’est pourquoi l’extraction des données de Zillow peut être très utile dans vos outils et applications tierces pour les besoins de l’immobilier commercial.

Les données que nous récupérons de Zillow contiennent des informations sur la liste des maisons à vendre dans n’importe quelle ville de leur base de données. Les données extraites peuvent être exportées dans différents formats tels que .csv, .txt, et même .xlsx. Ces données incluent des informations telles que les adresses, le nombre de chambres à coucher, le nombre de salles de bain, le prix, et bien d’autres encore.

Peut-on scraper Zillow ?

Scraper les informations immobilières sur le site Zillow est l’une des dernières tendances en matière d’achat de maisons et peut vous donner un avantage concurrentiel si elle est utilisée à bon escient. Avant de vous lancer dans l’aventure de Zillow, il y a des règles à respecter pour ne pas enfreindre les limites éthiques ou légales. Le web scraping des données disponibles à l’écran lorsque vous recherchez des maisons dans un lieu géographique donné n’est pas illégal.

Les informations sont disponibles pour toute personne ayant un accès à Internet et pouvant consulter le site Web sur un navigateur. Zillow a également permis l’utilisation de ses données par le biais de sa propre API. Cela facilite l’intégration commerciale avec le groupe Zillow sur le marché de l’immobilier. L’utilisation de l’API de Zillow est le meilleur moyen d’accéder aux informations à des fins commerciales sans violer l’éthique et les politiques de Zillow.

Comment scraper Zillow sans codage ?

Dans cette partie, nous allons vous dire comment récupérer les données de Zillow sans aucun codage. L’objectif est d’obtenir des détails sur l’adresse, le prix, le nom de la liste, l’agent immobilier désigné et toutes les informations disponibles sur le site Web. Pour cela, nous utiliserons l’outil de web scraping, Octoparse.

Octoparse est un outil de web scraping populaire, largement utilisé pour la collecte de données sur les sites Web. Pour utiliser pleinement ses fonctionnalités, vous n’avez besoin d’aucune connaissance ou expérience en codage, ce qui en fait l’outil idéal pour débuter dans le domaine du web scraping. Octoparse détecte automatiquement les données, les images, les pages et les listes des sites Web lorsque vous les ouvrez dans le navigateur intégré. Vous pouvez ainsi extraire les données de plusieurs pages d’un même site Web. Il permet également de télécharger des données en vrac à partir de 10 000 liens en une seule fois. Octoparse utilise également l’API de Zillow, de sorte que nous n’avons pas à nous soucier des problèmes éthiques et juridiques lors de l’extraction d’informations sensibles.

Étape pour scraper facilement les données de Zillow avec Octoparse

Étape pour scraper facilement les données de Zillow avec Octoparse

Pour commencer, vous devez télécharger et installer Octoparse sur votre appareil et vous inscrire à un compte gratuit si vous êtes un nouvel utilisateur. Ensuite, suivez les étapes simples ci – dessous ou demandez de l’aide au centre d’aide Octoparse.

Étape 1 : Coller le lien Zillow dans Octoparse

Copiez l’URL que vous voulez récupérer de Zillow et collez-la dans la boîte de recherche d’Octoparse. Cliquez sur le bouton Démarrer pour entrer le mode de détection automatique par défaut.

Étape 2 : Créer un crawler de données sur Zillow

Après une détection rapide, cliquez sur le bouton Créer un flux de travail. Vous pouvez modifier les champs de données sur le panneau de Tips.

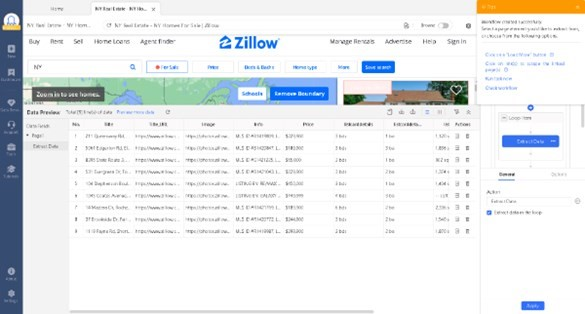

Étape 3 : Prévisualiser les données de Zillow et les extraire

Dans le bas de l’écran, vous pouvez observer que les données à extraire sont affichées dans un tableau. Vérifiez s’il contient toutes les données nécessaires. Si non, sélectionnez simplement les données dont vous avez besoin et elles seront ajoutées à une nouvelle colonne. Les noms des champs peuvent être renommés en les sélectionnant dans la liste prédéfinie ou en les saisissant vous-même.

Cliquez sur le bouton Exécuter pour démarrer la tâche d’extraction de données sur l’appareil. Une fois la tâche terminée, vous pouvez l’exporter vers le système local dans le format désiré.

Scraper Zillow avec Python

Zillow a l’un des plus grands volumes de données parmi les principaux sites d’annonces immobilières. Scraper ses données peut être d’une grande utilité pour les agents immobiliers ou d’autres personnes ayant un intérêt commercial pour les annonces. Le scraping web a été rendu facilement réalisable par divers modules et méthodes construits à l’aide de python. Parmi les paquets largement utilisés pour le scraping de données sur le Web, citons Beautiful Soup, Mechanical Soup, Selenium, Scrapy, etc.

Dans la section suivante, nous utiliserons Beautiful soup pour obtenir des données de Zillow. Ouvrez n’importe quel IDE Python. Lancez le code suivant. J’ai utilisé PyCharm ici.

Panda Donnée box “Df” contient des informations de liste pour Manhattan, New York. La procédure comprend un cycle d’extraction des prix et des adresses des maisons cotées. Vous pouvez l’étendre en scrapant d’autres données, comme le nombre de chambres, salles de bains, etc. Vous pouvez l’enregistrer en tant que fichier CSV local en utilisant la fonction : df.to_csv(‘file_path’). Saisissez le moyen et le nom du fichier CSV au lieu de file_path.

En conclusion

Les perspectives de l’immobilier numérique évoluent rapidement avec de nouveaux services et outils apparaissant presque quotidiennement. Au cours des dernières années, Zillow a continué de croître considérablement, devenant l’un des plus grands sites et services immobiliers au monde. Le principal modèle de l’entreprise est de fournir aux utilisateurs de l’information sur les maisons à vendre, les tendances du marché du logement et d’autres données relatives.

Maintenant que vous avez appris les bases de la façon du Web scraping, l’étape suivante consiste à générer des idées pour tirer le meilleur parti de l’information obtenue. Explorez plus de fonctionnalités Octoparse et d’autres Web scraping méthode de Python pour augmenter votre capacité et votre fluidité en utilisant le Web scraping pour récupérer des informations.